Компанія OpenAI презентувала GPT-4o (“о” — від “омні”), свою найновішу багатомодальну модель, яка працює з текстом, голосом, зображенням і відео в режимі реального часу. Це — новий стандарт взаємодії людини з ШІ.

За офіційним блогом OpenAI, GPT-4o здатна сприймати голос із затримкою лише 232 мс — це порівнювано з людською мовою. Модель вміє емоційно відповідати, розуміти інтонацію, перемикатися між мовами й тоном.

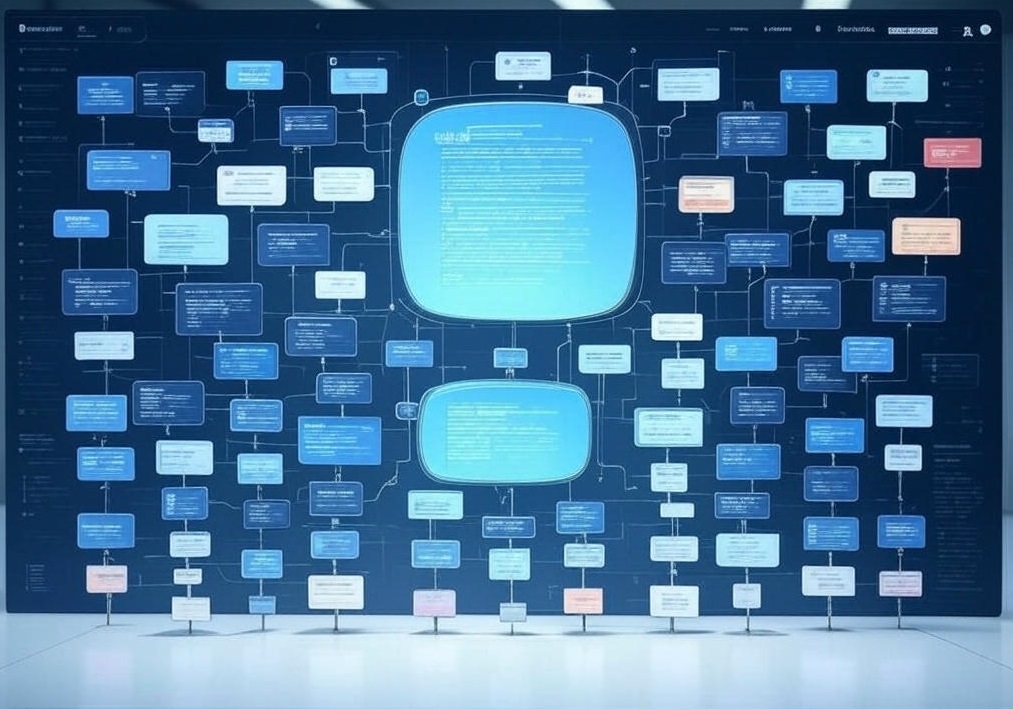

На відміну від попередніх моделей, GPT-4o — нативно мультимодальна. Вона була навчена працювати з усіма типами даних одночасно, без окремих модулів. Уявіть собі голосового помічника, що не лише чує, а й “бачить”, “відчуває” інтонацію, розпізнає міміку — і все це в режимі live.

Як повідомляє The Verge, GPT-4o розмовляє багатьма мовами, миттєво описує зображення, виражає емоції. CNN додає, що модель вже доступна в ChatGPT — у безкоштовному режимі з базовими функціями, а підписники отримають розширений доступ і API.

У час зростання конкуренції з боку Google Gemini та Meta LLaMA 3, ця модель може стати найбільш “людяною” версією ШІ. Вона обіцяє кращу доступність, природну розмову, нові можливості в освіті, підтримці клієнтів та медіа.

GPT-4o — це не просто оновлення. Це зміна парадигми спілкування з ШІ.